你好,我是郑工长。

你有没有遇到过这种情况:同样一个问题,你换种方式问ChatGPT,它的回答质量就天差地别?前一秒它还是无所不知的“学霸”,后一秒就变成了满嘴胡话的“学渣”。

很多人把这归结为AI的“不稳定性”或者“抽风”。但今天,一个来自韩国浦项科技大学的最新研究,为我们揭开了这个“玄学”背后的科学原理。

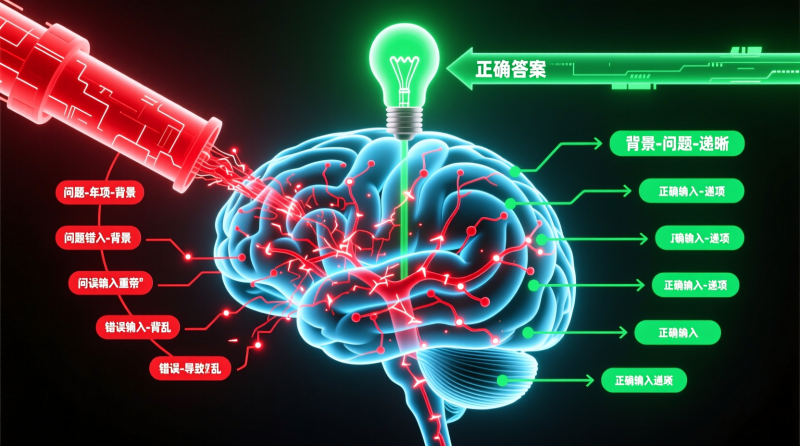

研究发现,仅仅是调整向大模型提问时“背景、问题、选项”这三者的顺序,就能让它的回答准确率,产生高达14.7%的差异!

这背后,是一个极其重要的、关于如何与AI高效沟通的“第一性原理”:

大型语言模型不是一个能随时随地精确检索的“数据库”,而是一个极度依赖上下文的、基于概率的“序列生成器”。它的每一次回答,都严重依赖于它“看到”的前文语境(Context)。改变输入的顺序,就是改变了它的“初始心境”,自然会影响最终的“思维路径”。

为什么“读题顺序”如此重要?

我们人类做选择题,习惯的顺序是“先读题干,再看选项,最后如有需要再回顾背景材料”。

但AI不是人。

研究发现,对于AI来说,最高效、最准确的“读题顺序”是:

先给背景 (Context) -> 再给问题 (Question) -> 最后给选项 (Options)。

为什么?

- 先给背景: 这相当于为AI的大脑,预先加载好一个“知识场”。所有后续的计算,都会在这个被限定的、相关的知识场内进行,极大地排除了不相关信息的干扰。这就像给它画了一个“重点范围”。

- 再给问题: 在有了“重点范围”之后,再告诉它具体要在这个范围内计算什么。这时,它的“注意力”是高度集中的。

- 最后给选项: 当它已经根据背景和问题,在内部“算”出了一个大概率的答案方向后,再让它从选项中做“选择”,就变成了一个更简单的“匹配”或“确认”任务,而不是一个开放式的“搜索”任务。

反之,如果你先抛出问题,AI会在它那庞大到无边际的知识库里进行“大海捞针”式的搜索,它的“思维”是发散的。这时你再给它背景和选项,它很可能已经走上了一条错误的思维岔路,很难再被拉回来。

从“使用者”到“提问工程师”

看明白了吗?这个看似微小的“顺序”差异,本质上反映了我们与AI协作的两种不同段位:

- 普通使用者: 把AI当成一个“人”来对话,用符合人类习惯的、模糊的方式去提问。得到的结果,自然也充满了不确定性。

- 高级玩家(提问工程师): 把AI当成一个“系统”来调用,深刻理解其“依赖上下文”的运行原理,通过精巧地设计“输入序列”(即Prompt),来主动地、精确地“引导”和“构建”AI的思考路径,从而获得高质量、高稳定性的输出。

这就像驾驶一辆手动挡的赛车。普通人只会踩油门,而专业赛车手懂得在每一个弯道前,通过精确的降档、补油,来为出弯时的加速,创造最佳的引擎状态。

郑工长总结:掌握AI的“脾气”

AI是有“脾气”的,这个“脾气”,就是它底层的运行逻辑。

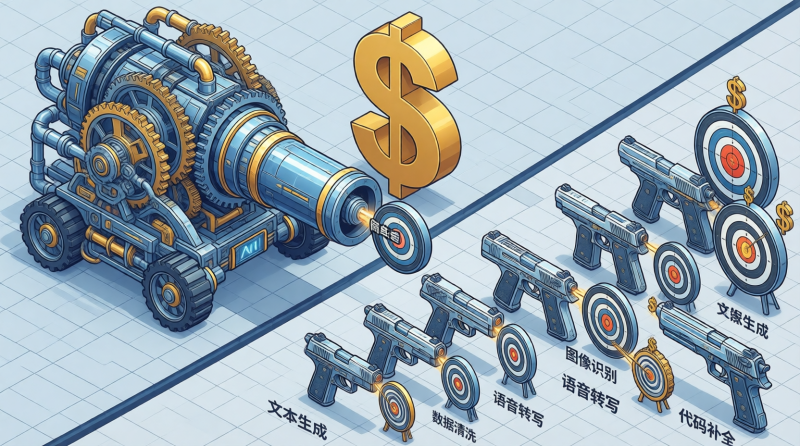

这次关于“读题顺序”的研究,只是冰山一角。它提醒我们,想要把AI从一个偶尔能带来惊喜的“玩具”,变成一个稳定可靠的“生产力武器”,我们必须停止用对待“人”的方式去对待它。

我们必须开始学习成为一个“提问工程师”,去研究、去测试、去掌握它的“脾气”:

- 什么样的句式,能让它更好地理解意图?

- 什么样的角色扮演,能让它输出的风格更稳定?

- 什么样的示例(Few-shot),能让它举一反三?

这14.7%的性能差异,就是“业余玩家”和“专业选手”之间的差距。而这个差距,在未来的工作中,将直接决定你的产出效率和最终价值。