你好,我是郑工长。

最近有两个关于AI的新闻,放在一起看,非常有意思。

一个,是有人搞了个“AI带我炒股”的实测,结果发现AI的表现天差地别,有的赚了10%,有的几乎不赚钱。一句话总结:让AI替你做决策,很不靠谱。

另一个,是某地人大,已经开始用AI大模型来辅助进行“预算审查”。AI像一个不知疲倦的审计员,从海量的预算报告中发现各种潜在问题。一句话总结:让AI帮你找问题,非常靠谱。

这背后,就引出了当前AI落地最核心的一个问题:我们到底该如何“使用”一个我们不完全信任、时常犯错的AI?

场景决定成败:为什么AI炒股不行,审预算就行?

从工程师的视角看,答案不在于AI本身“聪明”或“愚蠢”,而在于它所处的“工作环境”。

炒股:一个“开放、对抗、高噪音”的环境

- 开放与对抗: 股市是一个开放系统,充满了无数无法预测的宏观因素和“对手盘”的人性博弈。你赚钱,就意味着有人亏钱。AI面对的,是一个动态变化的、充满欺骗和对抗的“战场”。

- 高噪音: 绝大部分市场信息都是“噪音”,而非有效的“信号”。AI很容易在海量噪音中,做出错误的归因,导致“刻舟求剑”式的决策。

- 让AI当“决策者”: 在这里,我们让AI扮演了“决策者”的角色,要求它对未来的不确定性负责。这超出了它当前的能力。

审预算:一个“封闭、协作、低噪音”的环境

- 封闭与协作: 预算报告遵循严格、固定的会计准则和法规。AI的任务,是在一个有明确规则的“封闭系统”里,与人类审计员“协作”,而不是对抗。

- 低噪音: 数据格式是标准化的,目标是明确的——找出不符合规则的、异常的项目。噪音少,信号明确。

- 让AI当“审计员”: 在这里,我们让AI扮演了“审计员”或“不知疲倦的筛查工具”的角色。它不负责最终决策,只负责“发现疑点”,然后把这些疑点交给人类专家去最终判断。

郑工长定律:人机协同的“边界理论”

这就引出了一个关于如何使用AI的工程学定律,我称之为“人机协同的边界理论”:

一个AI应用的可靠性,不取决于AI模型本身有多完美,而取决于我们在流程中为它设定的“角色”和“边界”有多清晰。

用好一个不完美的AI,本质上是一个“管理问题”。关键在于做好“定岗定责”:

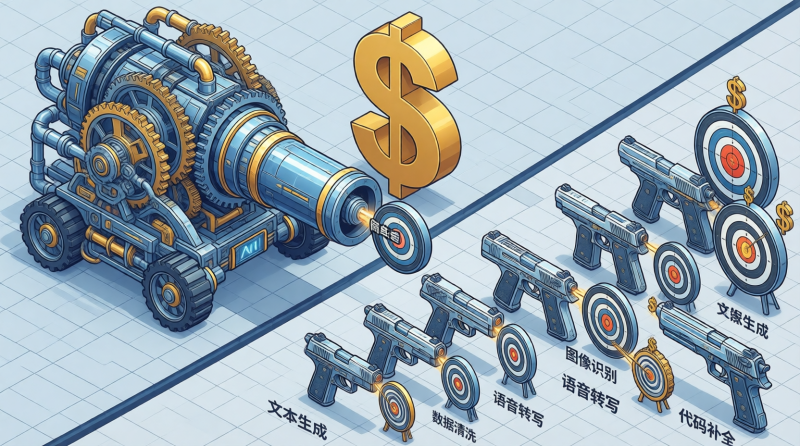

- 让AI做“量”的工作: 把那些需要海量信息处理、重复模式匹配、不知疲倦筛查的工作交给AI。例如,审查几千页的合同、校对上万字的文档、从财报里提取所有关键数据。

- 让人类做“质”的工作: 把那些需要理解复杂人性、进行价值判断、承担最终责任的决策,留给人类自己。例如,判断一个合同条款是否“公平”,决定一笔预算是否“合理”,下一个买入或卖出的“指令”。

总结:从“AI会不会?”到“我该让AI干什么?”

所以,不要再问“AI能不能帮我炒股?”这种问题了。

你应该问自己:在“炒股”这个复杂的流程里,有哪些环节,是可以被AI这个“超级工具”赋能的?

例如,你可以让AI帮你“阅读分析所有相关的研报”,而不是让它帮你“决策买哪一只”。你可以让AI帮你“监控市场情绪的异常波动”,而不是让它帮你“决定什么时候卖”。

停止将AI视为一个无所不能的“先知”,开始将它看作一个能力边界清晰的“超级工具箱”。想清楚**“我该让AI干什么”,远比关心“AI会干什么”**,要重要得多。

这,才是我们工程师,使用一个不完美工具的务实之道。