你好,我是郑工长。

当我们讨论AI安全时,我们通常在讨论什么?是模型的偏见、输出的“幻觉”,还是AI被用于网络钓鱼。

但今天,我想聊一个更深层、更根本、也更具毁灭性的安全威胁,我称之为“沉默的危机”——量子计算对AI基础设施的“降维打击”。

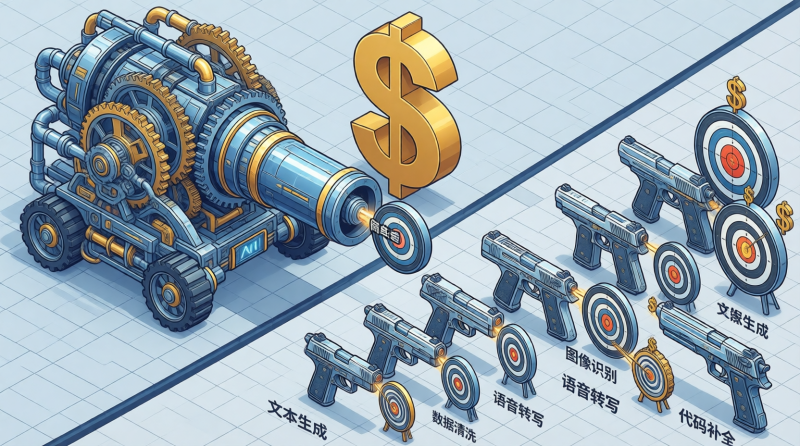

这是一个冰冷的现实:我们今天用来保护AI系统的一切,从模型本身的权重文件,到赖以生存的训练数据,再到服务器之间的通信链路,几乎都依赖于现有的公钥加密标准(如RSA、ECC)。而在未来的量子计算机面前,这些加密算法,将像一张纸一样被轻易撕碎。

这意味着:

- 你耗费数百万美元训练的、代表你核心竞争力的AI模型,可能被竞争对手轻易窃取。

- 你用来训练模型的、最宝贵的商业机密和用户数据,可能被完全解密,公之于众。

- AI系统的控制权可能被夺取,用于更危险的目的。

这是一种“釜底抽薪”式的威胁。我们一直在担心AI会不会“作恶”,但很少有人关心,当AI本身被“一锅端”了,会发生什么。

一个工程定律:

一个系统的安全性,取决于它最薄弱的一环。对于AI系统而言,在量子时代,这个最薄弱的环节,就是它的“密码学地基”。

这场危机之所以“沉默”,是因为它不像模型幻觉那样每天都能看到,它的威胁来自于未来。但恰恰因为如此,它才更危险。因为我们今天用现有加密算法保护的所有数据,都正在被“先窃取,后解密”(Harvest Now, Decrypt Later)。等到量子计算机真正可用的那一天,一切都晚了。

因此,我们的安全防火墙,需要一次“跨代升级”。

对于我们工程师而言,是时候在自己的知识体系里,为“后量子密码学”(Post-Quantum Cryptography, PQC)留出一个重要的位置了。

- 主动学习: 了解PQC的基本原理和NIST(美国国家标准与技术研究院)正在推进的标准化算法(如CRYSTALS-Kyber, CRYSTALS-Dilithium等)。

- 评估风险: 审视你正在构建的AI系统,哪些环节的数据是长期敏感的?哪些通信链路是需要“抗量子”保护的?

- 预留方案: 在系统设计之初,就考虑“密码学敏捷性”(Crypto-agility),为未来的加密算法升级,预留好接口和方案。

AI安全,不仅要防“AI自身作恶”,更要防“未来的幽灵”。在AI这座摩天大楼的地基里,必须提前埋下“抗量子攻击”的钢筋。否则,今日的辉煌,都可能成为明日的废墟。