你好,我是郑工长。

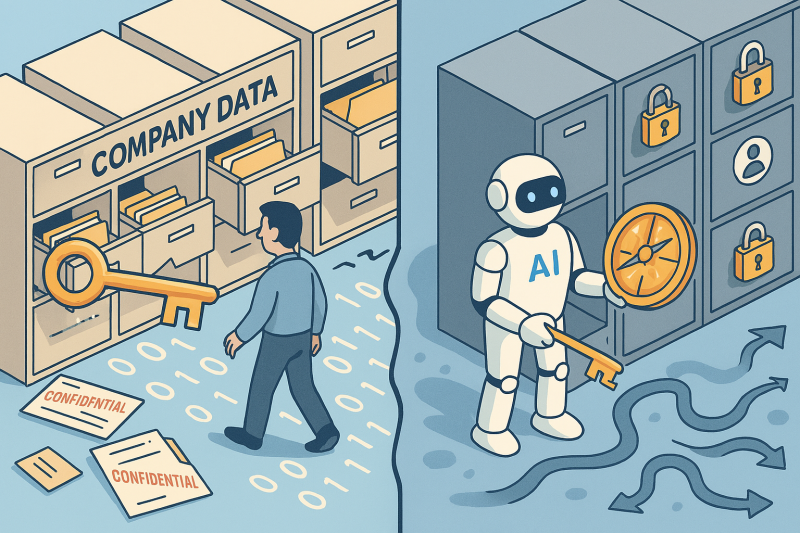

RAG(检索增强生成)技术,现在几乎是所有企业构建内部AI知识库的标配。它让AI能言善辩,还能引经据典。但最近的一份安全报告,揭示了一个被很多人忽略的“致命”盲区:你的AI知识库,可能正在把公司的保密文件,喂给任何一个提问的人。

这个问题,源于一个天真的假设:以为AI能自动理解数据的“敏感级别”。

这就好比,你为了方便,给了新来的实习生一把“万能钥匙”,让他可以进入公司的所有房间,包括档案室和CEO办公室。你指望他能凭“自觉”不去乱翻,这现实吗?

AI Agent,就是那个能力超强、但没有任何“自觉”的实习生。在它眼里,数据没有“密级”,只有“相关度”。当你问一个问题时,为了给你最“相关”的答案,它会毫不犹豫地把CEO的薪资表、未公开的财报、和下午茶的菜单,一并打包塞给你。

我们得到的不是一个智能助理,而是一个“毫无纪律的泄密者”。

一个工程定律:

在安全领域,任何依赖于“自觉”而不是“规则”的系统,都必然会崩溃。

所以,AI的安全问题,从来不是一个虚无缥缈的“AI伦理”问题,它是一个经典的、严肃的“访问控制”工程问题。我们的工作,不能止步于“优化检索”,更要回归到“设计权限”:

- 为数据上锁: 在数据进入AI系统之前,就必须完成清晰的、基于角色的权限标记。

- 为AI划定边界: 在AI给出答案的最后一刻,必须有一个权限校验模块,确保它没有拿出不该拿出的东西。

我们不仅要构建AI的“知识图谱”,更要构建它的“权限边界”。这才是真正负责任的AI工程。