所有文章

ChatGPT“接广告”:当AI开始凝视你的钱包,用户和信任何去何从?

发布于 2026年1月18日

OpenAI官宣将在ChatGPT免费版和低价Go版中测试广告模式,标志着AI从“技术驱动”全面转向“商业驱动”。本文从“郑工长”视角,深入探讨广告模式这把“双刃剑”:它能带来巨大现金流,但也可能损害用户体验、引发隐私争议。文章呼吁AI创造者坚守工程伦理,确保AI在“商业化”与“用户信任”之间找到平衡,不以隐私为代价换取增长。

Cursor的“百万行代码”闹剧:戳破AI泡沫,回归工程师的实事求是

发布于 2026年1月17日

AI编程工具Cursor创始人承认“AI Agent帮我们写了上百万行代码”为夸张的营销说辞,给狂热的AI信徒泼了盆冷水。本文从“郑工长”视角,剖析了这起“牛皮吹破”事件背后的深层问题:为了融资和吸引用户,AI领域的营销话术正严重脱离技术现实,伤害了工程师“实事求是”的文化根基。文章呼吁工程师主动“祛魅”,客观看待AI的能力边界,用真实可量化的结果说话。

苹果+Google的“AI同盟”:这不是投降,这是“生态位战争”

发布于 2026年1月17日

苹果宣布将在下一代产品中深度集成Google Gemini,这一“世纪联手”震惊业界。本文从“郑工长”视角,剖析其背后深刻的战略逻辑:这不是投降,而是两大巨头为对抗“微软+OpenAI”联盟而进行的“生态位互补”。当竞争从“单点产品”升级为“完整技术栈”的生态战争,找准自身在巨头生态中的位置,成为所有开发者的核心课题。

智谱AI+华为昇腾:我们自己的“铲子”,挖出了世界级的“金矿”

发布于 2026年1月17日

智谱AI与华为昇腾联手,在国产芯片上训练出国际顶尖的图文多模态模型,这不仅是技术突破,更是“自主可控”的胜利宣言。本文从“郑工长”视角,将算力比作“铲子”,指出这一成就打破了“国产算力不行”的迷信。当算法能在国产硬件上跑出世界级结果,“软硬协同”的自主生态飞轮才算真正转动,工程师也终于可以在“自己的土地上”,构建完整的AI技术栈。

阅读全文 →

0.2%的商业化率:美的集团1000个AI Agent揭示的残酷真相

发布于 2026年1月17日

美的集团内部开发超1000个AI智能体,最终仅2个投入商业化使用,0.2%的转化率震惊行业。本文从“郑工长”的工程师视角,剖析了从“技术可行”到“商业有价值”的巨大鸿沟。文章指出,99.8%的智能体死于无法解决真实的商业问题,如业务流程理解、数据孤岛和安全合规。工程师的使命,应从追求“数量”转向追求“价值转化率”,一个能赚钱的Agent胜过一千个Demo。

阅读全文 →

AI大模型的“35天魔咒”:如何穿越“洗牌期”,构建稳定AI产品?

发布于 2026年1月17日

AI大模型霸主平均35天易主的残酷现实,揭示了“AI大洗牌”时代的极度不稳定。本文从“郑工长”的工程师视角,深入探讨了在模型能力“涌现”与产品价值“稳定”之间的核心矛盾。文章强调,真正的护城河不是追逐最强模型,而是构建一个与模型解耦的灵活架构,确保产品能够穿越频繁的模型更迭期,为用户提供持续稳定的服务。

郑工长·AI洞察|2026.01.17·35天换霸主!AI大洗牌,智能体商业化真相曝光!

发布于 2026年1月16日

今天AI圈彻底炸锅!LMSYS榜单残酷揭示:大模型“霸主”平均在位仅35天就凉凉;更扎心的是,美的辛辛苦苦打造1.3万个智能体,最终能商业化的只有区区千分之二!一边是Cursor号称AI写300万行代码造浏览器,却被全网群嘲为“AI泔水”,另一边,智谱与华为联手训练的GLM-Image却悄然登顶国际榜单,为国产算力狠狠争了口气。

AI没有“中立”:警惕GPT-5背后隐藏更深的偏见

发布于 2026年1月17日

OpenAI发布GPT-5,声称显著降低了偏见,但这可能是一个危险的误解。本文从“郑工长”的视角,深入探讨了“AI中立性”的本质伪命题。通过“镜子”比喻,文章阐明AI模型只是其训练数据的反映,一个更强大的模型可能只是将偏见隐藏得更深。工程师的责任已从“消除偏见”转向“理解并管理偏见”,这需要全新的工具和思维。

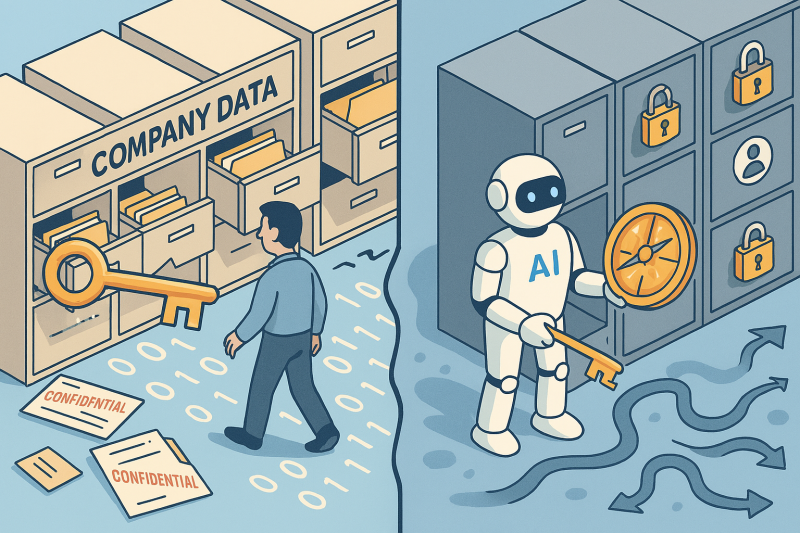

AI知识库的“致命”盲区:当RAG变成“泄密工具”

发布于 2026年1月17日

RAG(检索增强生成)被誉为企业知识库的未来,但近期的安全报告揭示了其“致命”的权限漏洞。本文从“郑工长”的工程视角,通过“万能钥匙”比喻,阐明了没有权限控制的RAG系统,如何从智能助理变为“无纪律的泄密者”。文章强调,AI安全的核心是经典的“访问控制”工程问题,工程师的责任是为数据“上锁”,为AI“划定边界”。

AI能写72%的“正确”代码,但工程师的价值在于100%的“审计”

发布于 2026年1月17日

Mistral的AI模型在编码基准测试中获得72.2%的高分,但这是否意味着人类代码审查的终结?本文从“郑工长”的视角,论证了恰恰相反的观点。AI越擅长写出“逻辑正确”的代码,人类工程师的价值就越体现在对代码背后“商业逻辑”、“安全逻辑”和“伦理逻辑”的100%审计上。工程师的角色正从“代码工人”升维为“代码审计师”和“风险控制官”。